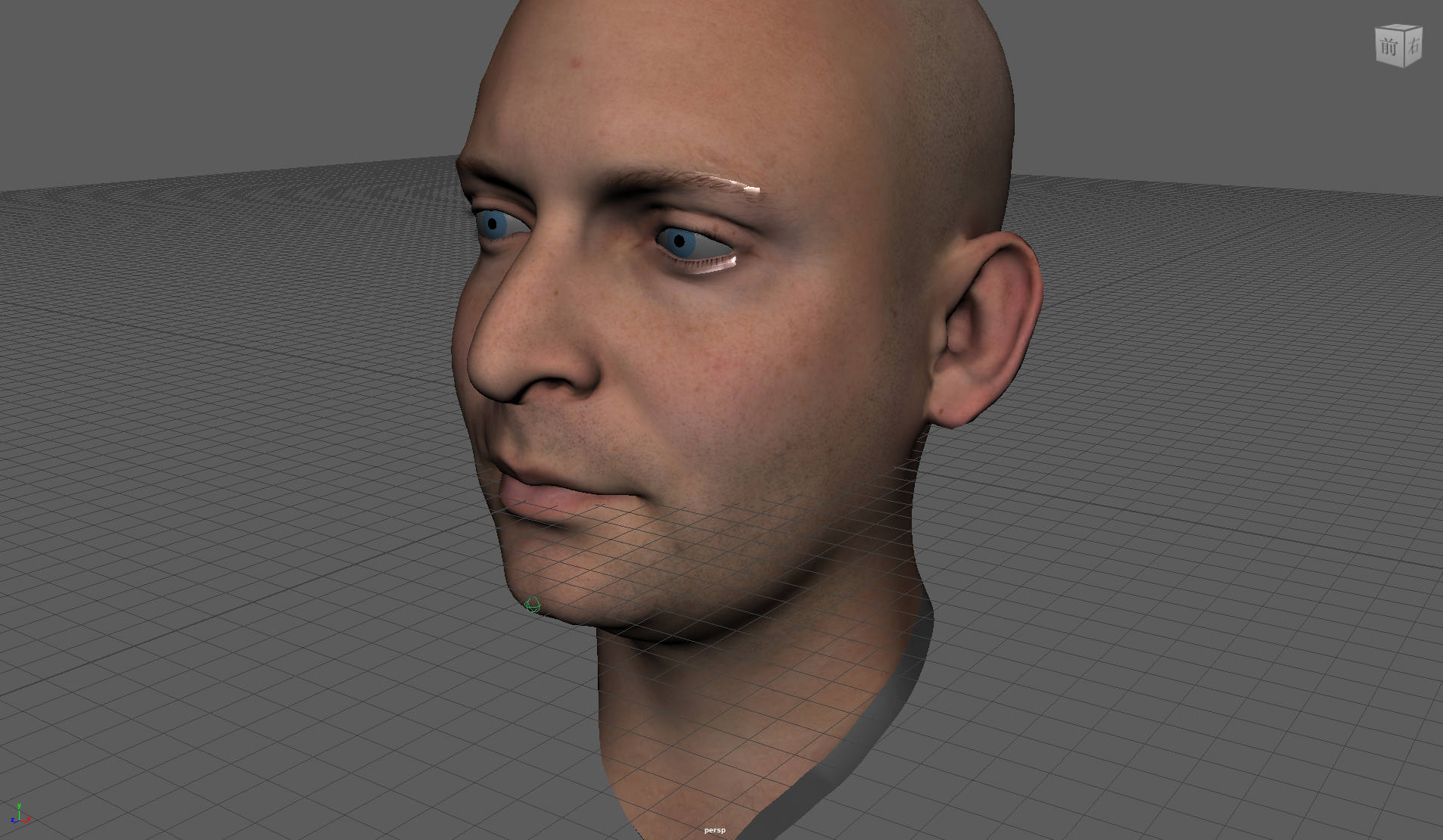

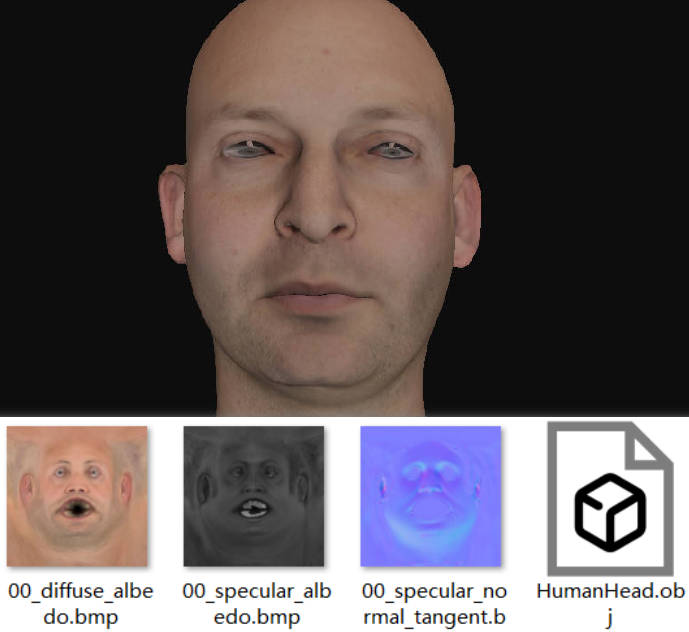

上学期收到作业附件时,关于这个脑袋与SSSS的资源只有区区6页的一个slide,obj与diffuse,normal,specular三张贴图。

之前动视暴雪中皮肤的部分已经基本实现完了,但眼睛的渲染优化

GDC2013 Next Generation Character Rendering

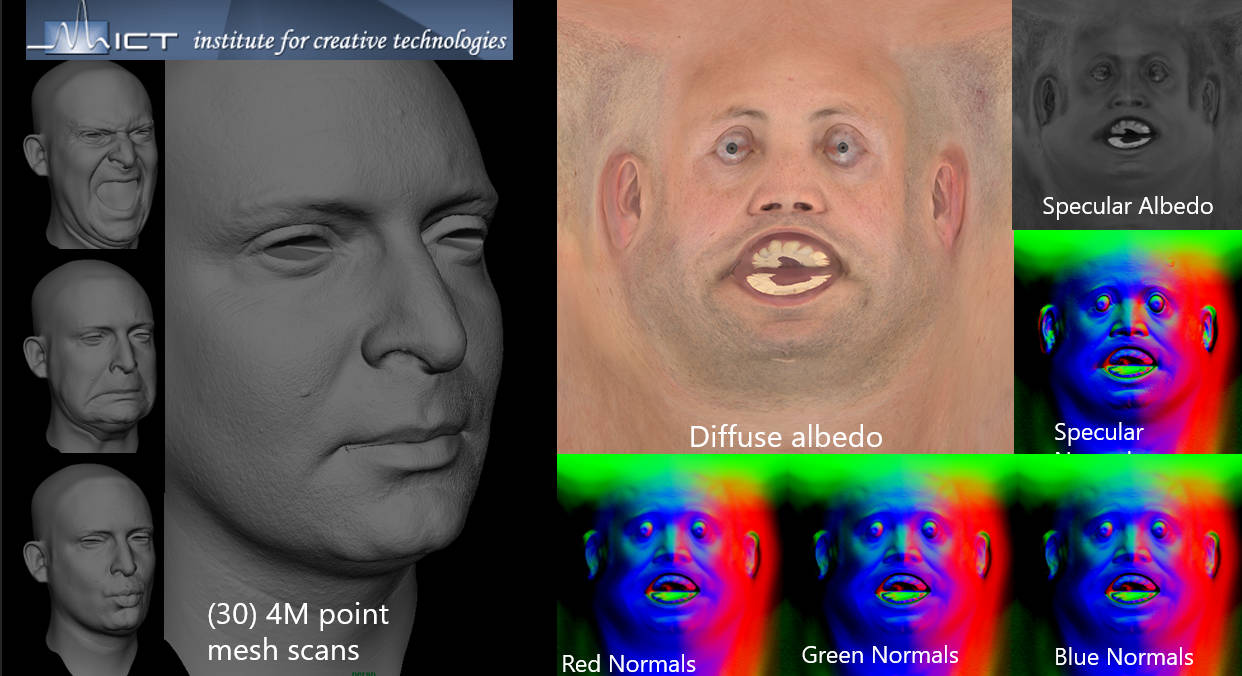

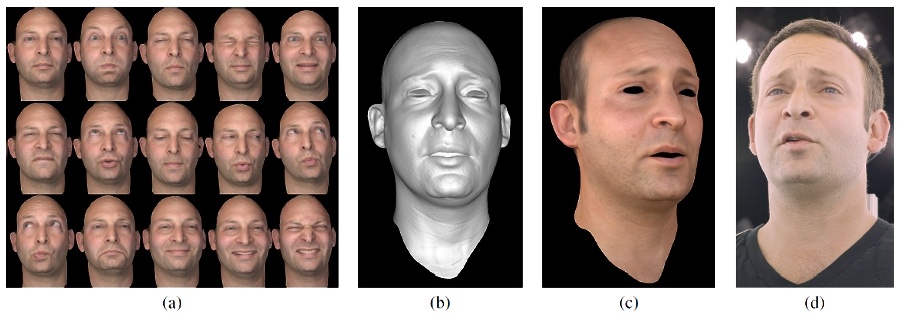

溯源从之前暴雪GDC渲染的Animation部分开始,讲座介绍模型及表情的数据来自Graphics Lab of the Institute of Creative Technologies of USC,使用Lightstage X扫描。

在ICT USC的网站中详细介绍了近年来的工作,在2014年其发表了与视频驱动的表情捕捉相关的论文,其题图正是我们要找的这位仁兄!

文末的相关项目为我们指明了前路:Digital Ira,发布于2013年,是专为实时渲染而扫描制作的人脸数据集。

(顺便吐槽一下ICT网站,大概是前些年换过域名,所有的站内超链接通通失效,,得单独去谷歌题目才行)

Digital Emily

但Ira其实并非ICT扫描的第一个数字人,在2008年,ICT扫描了Emily O'Brien,并开展了Digital Emily项目。

扫描使用了15张不同光照的照片以计算面部的几何形状和反射率。通过使用不同的光源角度和偏振器,我们能够得到diffuse+specular的图像以及滤除高光的纯diffuse图像,从而观察面部的高光反射。不过这里的'specular'图像不是完全黑白的,这是因为部分光线反射前已经经历过一次散射,改变了色光的比例。

高光图是法线计算的重要依据,通过视线向量和光线向量可以反推出面部法线。

刚刚提到不同色光的分布在高光中分布并不一致,不同色光分量得到的法线图也是不一样的:红光散射的最远,因此法线细节会柔和许多。

好消息是,Digital Emily的模型、贴图是开源的,在Wikihuman Project下可以获取Emily的完整Maya场景与Shader文件。

(题外话——写完才想起来,这个项目之前动画原理课讲人脸动画时就讲过哇!)

Hi Ira

Ari Shapiro是该实验室的图形研究员,Digital Ira项目旨在创建一个实时的、照片真实的数字人物,数据集也分享给了Nvidia和动视暴雪,以进行技术演示(That's why we found him!) 。 Digital Ira与GDC2014的Digital ira and beyond可以获取更多关于Ira模型生成、表情系统构建的信息,但ICT并没有对Ira的模型及纹理信息进行公开:((((

不过这篇文章详细介绍了Nvidia的Ira和动视的Ira,荐读一下👈

于是我们只好把目标转向拿到了数据的Nvidia和动视暴雪。Nvidia于2013年发布了这个面部渲染的Demo,可以在这里下载。

悲报是,作为一个成熟的demo,它的所有资源打包成了apk.......而我并不会解包......

悲报是,作为一个成熟的demo,它的所有资源打包成了apk.......而我并不会解包......

Ira会面之旅就此卡住。我试了好多不同的关键词组合都没有找到新的内容——直到把Ira踢出了搜索框,转而搜索上述demo的项目名FaceWorks,终于找到了这个demo的Github开源版本😭😭😭😭

其模型等资源位于Faceworks/samples/media/DigitalIra.贴图的命名与作业附件的材料都是一致的,说不定之前助教也是从这里存下来的嘞💫

很高兴为Ira找回了眼睛和一丢丢毛发(以及maya的反光shader)!Nvidia的demo版本中并没有使用动视暴雪提到的眼周高光与虹膜渲染的优化,所以没有提供Jorge等人使用的泪光闪闪mesh&睫毛遮罩贴图等。下一篇我们就尝试复现一下暴雪眼部渲染的优化流程!期待!